robots.txt 文件中封禁CSS与JS文件的做法是否正确?既然提出了这个问题,说明答案肯定是否定的,我们在以往对robots文件的操作中经常会将CSS与JS文件屏蔽掉,因为觉得蜘蛛爬行这些文件后没什么用,而且大量的爬行记录也搞的很烦人。

其实,这种观点从现在开始需要整改一下了,早在几年前,google站长工具明确说明:封禁CSS与JS调用可能会影响页面质量的判断,进而影响到排名。同样,经常关注SEO动态的朋友可能知道,百度官方最近也给出了对此现象的处理意见,大体如下:百度现状也可以抓取JS执行调用来解析调用的内容。因此,如果你封禁了网站的CSS和JS,站点肯定会受到影响!

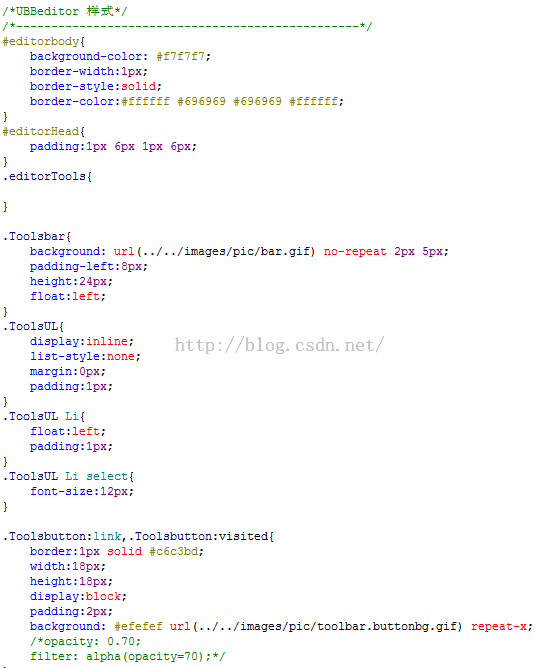

如何处理CSS与JS文件,那就是一个技术活了,只能通过优化的思路去解决这个问题。

希望大家能够多了解SEO的一些现状和发展,及时更正错误观以及学习新的SEO知识,做到永不退步,学以致用。

呵呵

0 人

震惊

0 人

赞

0 人

鄙视

0 人

流泪

0 人